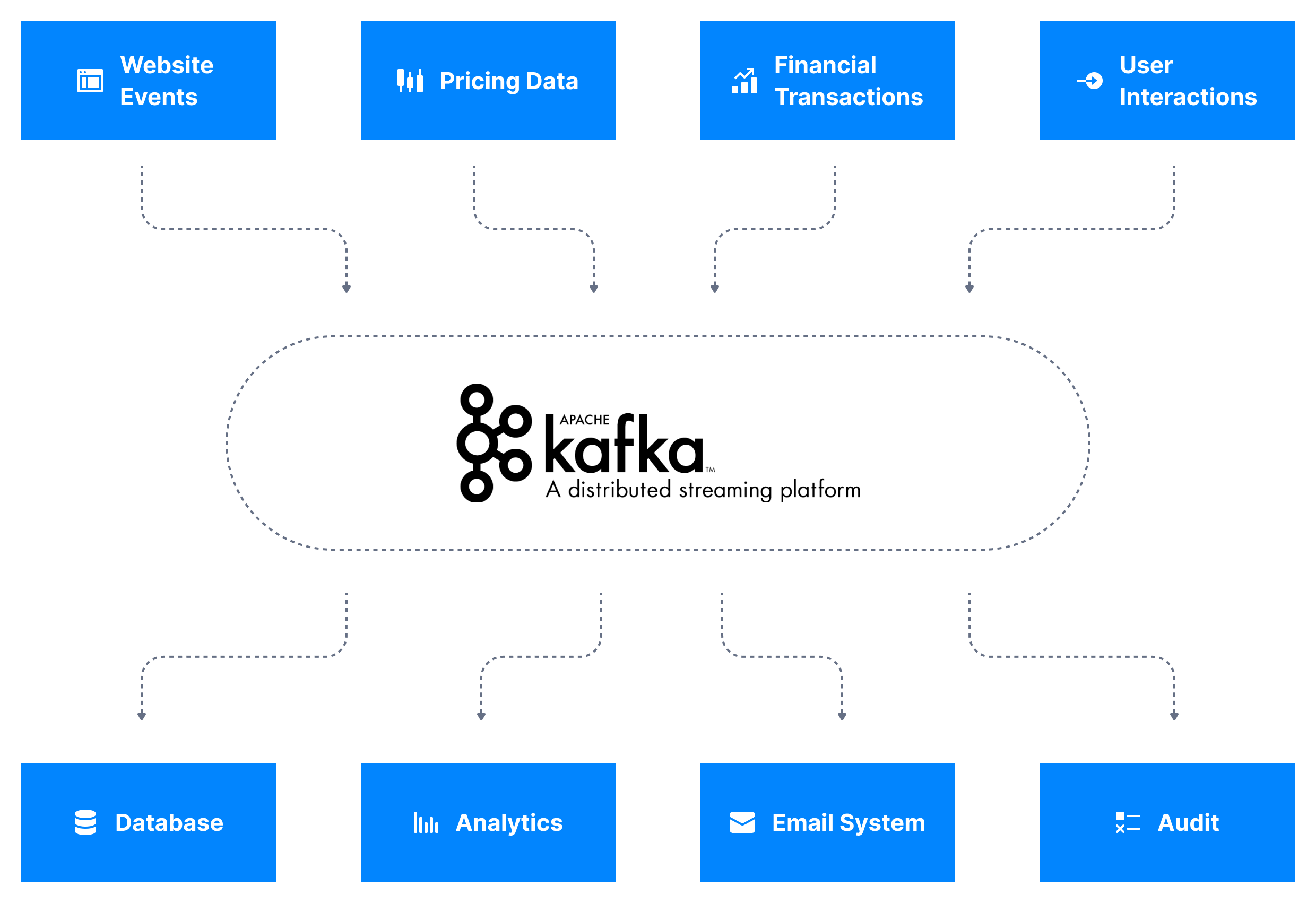

کافکا (Apache Kafka) یک پلتفرم متنباز برای پردازش و مدیریت جریانهای داده به صورت لحظهای است. این فناوری که توسط شرکت لینکدین توسعه یافته و در سال ۲۰۱۱ متنباز شد، برای مدیریت حجم بالایی از دادهها طراحی شده است.

کافکا در دستهبندی سیستمهای استریمسازی رویدادها قرار میگیرد، به این معنا که دادهها را از منابع مختلف جمعآوری کرده، بهصورت لحظهای پردازش میکند و به مقصدهای مختلف ارسال مینماید. به دلیل معماری توزیعشده و توانایی بالای آن در مقاومت در برابر خرابیها، این ابزار به یکی از راهحلهای اصلی برای ایجاد پایپلاینهای داده و برنامههای استریمینگ تبدیل شده است.

طراحی سیستم توزیعشده Kafka با مقیاسپذیری و دسترسیپذیری بالا

Apache Kafka ابزاری قدرتمند برای پردازش دادهها در لحظه است و به دلیل ماهیت توزیعشده، قابلیت مقیاسپذیری بالایی دارد. با این حال، برای مقیاسدهی کارآمد Kafka و حفظ دسترسی حتی در شرایط خرابی اجزای سیستم، طراحی دقیقی لازم است. در ادامه، مفاهیم اصلی و مراحل کلیدی به شکلی سادهتر شرح داده شدهاند:

چگونه معماری Kafka از مقیاسپذیری پشتیبانی میکند

Kafka با توزیع بار کاری میان چندین سرور (یا Broker)، امکان پردازش کارآمد حجم زیادی از دادهها را فراهم میکند. این امر با استفاده از چندین مؤلفه اساسی زیر ممکن میشود:

- موضوعها و پارتیشنها (Topics and Partitions): پیامها در Kafka به موضوعها سازماندهی میشوند. هر موضوع به بخشهای کوچکتری به نام پارتیشن تقسیم میشود. هر پارتیشن میتواند در یک سرور جداگانه ذخیره شود و این امکان را برای پردازش موازی داده فراهم میکند.

- تکثیر (Replication): هر پارتیشن به صورت تکراری در چندین سرور ذخیره میشود تا در صورت خرابی یک سرور، دادهها همچنان در دسترس باشند.

- تولیدکنندگان و مصرفکنندگان (Producers and Consumers): تولیدکنندگان دادهها را به موضوعها ارسال میکنند و مصرفکنندگان آنها را میخوانند. هر دو به صورت موازی عمل میکنند و کارایی را افزایش میدهند.

مراحل مقیاسدهی کافکا

۱. استفاده از پارتیشنها برای توزیع بار کاری

پارتیشنها یکی از روشهای کافکا برای تقسیم کار هستند. هر پارتیشن میتواند بهطور مستقل توسط یک Broker مدیریت و توسط یک Consumer پردازش شود.

بهعنوان مثال، اگر یک موضوع (Topic) دارای سه پارتیشن و سه مصرفکننده باشد، هر مصرفکننده یک پارتیشن را پردازش میکند.

- چگونه پارتیشنها را برنامهریزی کنیم؟

تعداد پارتیشنها را بر اساس حجم دادهها و نیاز مصرفکنندهها تنظیم کنید. تعداد کم پارتیشنها موازیسازی را محدود میکند و تعداد زیاد میتواند کارایی کافکا را تحت تأثیر قرار دهد. - بهترین روش: پارتیشنها را بهطور مساوی بین Brokerها توزیع کنید تا از بار اضافی روی یک Broker جلوگیری شود.

۲. افزودن Brokerهای بیشتر به کلاستر

وقتی حجم دادهها افزایش مییابد، میتوانید Brokerهای بیشتری به کلاستر کافکا اضافه کنید. این Brokerها پارتیشنهای جدیدی را میزبانی میکنند و بار کاری را کاهش میدهند.

- نحوه عملکرد:

اگر موضوعی دارای ۱۰ پارتیشن باشد و یک Broker جدید اضافه کنید، میتوانید پارتیشنها را مجدداً توزیع کنید تا هر Broker بخشی از آنها را ذخیره کند. این فرآیند به بازتخصیص پارتیشنها (Partition Reassignment) معروف است. - بهترین روش: نیازهای ذخیرهسازی، پردازنده (CPU) و شبکه Brokerهای جدید را پیشبینی کنید و پس از افزودن Brokerها عملکرد را نظارت کنید.

۳. تکثیر پارتیشنها برای اطمینان از پایداری

کافکا از Replication برای اطمینان از حفظ دادهها حتی در صورت خرابی یک Broker استفاده میکند.

بهعنوان مثال، اگر یک پارتیشن در Broker 1 ذخیره شده باشد، کافکا یک نسخه (Replica) در Broker 2 و Broker 3 ایجاد میکند.

- نحوه عملکرد:

یک Broker بهعنوان رهبر (Leader) برای هر پارتیشن عمل میکند و نسخههای دیگر بهعنوان نسخههای پشتیبان فعالیت دارند. اگر رهبر از کار بیفتد، یکی از نسخهها جایگزین میشود. - بهترین روش:

در محیطهای تولیدی، Replication Factor را حداقل روی ۳ تنظیم کنید تا هر پارتیشن دو نسخه پشتیبان داشته باشد.

۴. توزیع Brokerها در چندین دیتاسنتر

برای جلوگیری از خرابیهای گسترده، مانند قطعی برق یا مشکلات شبکه در یک مکان، Brokerها را در دیتاسنترهای مختلف مستقر کنید.

- نحوه عملکرد:

ابزارهایی مانند MirrorMaker در کافکا دادهها را بین کلاسترها در مکانهای مختلف تکرار میکنند. این تنظیمات باعث میشود حتی اگر یک دیتاسنتر بهطور کامل از دسترس خارج شود، سیستم همچنان فعال بماند. - بهترین روش:

تأخیر (Latency) انتقال داده را با تحمل خطا متعادل کنید. دیتاسنترها را در نزدیکی کاربران اصلی برای کاهش تأخیر انتخاب کنید.

استراتژیهای حفظ

دسترسیپذیری بالا

۱. تنظیم مناسب رهبر برای پارتیشنها

Kafka به صورت خودکار در صورت خرابی یک رهبر، یک نسخه پشتیبان را به عنوان رهبر جدید انتخاب میکند.

۲. تنظیمات تولیدکننده و مصرفکننده

- تولیدکنندگان: تنظیم تعداد تلاشها (Retries) برای ارسال مجدد پیام در صورت بروز خطا.

- مصرفکنندگان: استفاده از گروههای مصرفکننده برای توزیع کار.

۳. نظارت منظم بر سیستم

Kafka متریکهای مختلفی ارائه میدهد که برای شناسایی مشکلات و جلوگیری از توقف سیستم مفید هستند. ابزارهایی مانند Prometheus و Grafana میتوانند هشدارهایی برای مسائل حیاتی ایجاد کنند.

مثال واقعی

پردازش سفارشهای یک فروشگاه آنلاین

فرض کنید قصد دارید سیستمی برای پردازش لحظهای سفارشهای یک فروشگاه آنلاین ایجاد کنید، جایی که کاربران به طور مداوم در حال ثبت سفارش، مشاهده موجودی کالا، و بررسی وضعیت تحویل هستند:

مرحله ۱: شروع با یک کلاستر کوچک

در ابتدا، سه سرور (Broker) و شش پارتیشن ایجاد میکنید. هر موضوع (Topic) مرتبط با فعالیتهای مختلف مانند “ثبت سفارشها” یا “وضعیت انبار” به چند پارتیشن تقسیم میشود. این ساختار برای شروع مناسب است، زیرا حجم دادهها در این مرحله متوسط است.

مرحله ۲: افزایش ترافیک

با رشد فروشگاه و افزایش تعداد کاربران، تعداد سفارشها و درخواستها به شدت افزایش مییابد. در این مرحله، با نظارت بر سیستم، متوجه افزایش تأخیر در پردازش سفارشها میشوید؛ چرا که سرورها به دلیل حجم بالای دادهها تحت فشار قرار گرفتهاند.

مرحله ۳: افزودن Brokerهای جدید

برای حل این مشکل، سه سرور جدید به کلاستر اضافه میکنید. این کار باعث میشود پارتیشنها بین سرورها مجدداً توزیع شوند و بار کاری کاهش یابد. به این ترتیب، هر سرور وظایف سبکتری را انجام میدهد و توان عملیاتی سیستم افزایش مییابد.

مرحله ۴: تکثیر پارتیشنها برای اطمینان از پایداری

برای اطمینان از اینکه دادههای مهم مانند اطلاعات سفارشها در صورت خرابی سرورها از دست نرود، تکثیر پارتیشنها را فعال میکنید و ضریب تکثیر (Replication Factor) را روی ۳ تنظیم میکنید. این تنظیمات باعث میشود که هر پارتیشن در سه سرور مختلف ذخیره شود، و حتی در صورت از کار افتادن یک سرور، دو نسخه پشتیبان در دسترس باقی بمانند.

غلبه بر چالشهای رایج

۱. عدم تعادل در پارتیشنها

مشکل: پارتیشنها به طور مساوی بین Brokerها توزیع نشدهاند، که باعث میشود برخی از Brokerها بیش از حد بارگذاری شوند.

- راهحل: از ابزارهای داخلی Kafka مانند

kafka-reassign-partitions.shبرای بازتوزیع دورهای پارتیشنها استفاده کنید.

۲. بار اضافی متادیتا (Meta Data Overload)

مشکل: اگر تعداد پارتیشنها بسیار زیاد باشد، کنترلرهای Kafka ممکن است کند شوند، زیرا باید اطلاعات متادیتای هر پارتیشن را مدیریت کنند.

- راهحل: تعداد پارتیشنها را به نیاز واقعی محدود کنید و از ذخیرهسازی لایهای Kafka برای آرشیو دادههای قدیمی استفاده کنید.

۳. گلوگاههای شبکه (Network Bottlenecks)

مشکل: حجم بالای انتقال داده میتواند پهنای باند شبکه را اشباع کند.

- راهحل: فشردهسازی دادهها در سطح تولیدکننده و تنظیم دستهها برای ارسال دادههای بزرگتر اما کمتر.

نتیجهگیری

مقیاسدهی Kafka بهگونهای که هم ظرفیت بیشتری برای پردازش داده داشته باشد و هم در برابر خرابیها مقاوم باشد، با طراحی اصولی امکانپذیر است. با مدیریت مناسب پارتیشنها، افزودن Brokerها، تکثیر دادهها و نظارت بر عملکرد، میتوانید سیستمی بسازید که بدون مشکل حجمهای سنگین داده را پردازش کند و در شرایط بحرانی نیز پایدار بماند.

چه در حال پردازش تحلیلهای لحظهای باشید، چه دادههای IoT را مدیریت کنید یا سیستمهای مختلف را یکپارچهسازی کنید، این استراتژیها Kafka شما را برای نیازهای پردازش داده مدرن آماده میکنند.