زمانی که صحبت از عملکرد سرورها میشود، Uptime یکی از مهمترین معیارهاست. این شاخص نشان میدهد که یک سیستم تا چه اندازه پایدار و در دسترس است. امروزه سازمانها برای اطمینان از عملکرد مداوم خدمات خود، به 100% Uptime یا نزدیک به آن نیاز دارند. این مقاله راهنمایی جامع برای دستیابی به حداکثر Uptime ارائه میدهد.

1. سختافزار قابل اعتماد

انتخاب سرور مناسب

سرورها بهطور کلی در دو نوع طراحی میشوند:

- سرورهای برند شده

- برندهایی مانند Dell PowerEdge، HPE ProLiant و IBM System x از کیفیت بالایی برخوردارند.

- این سرورها اغلب دارای گارانتی و پشتیبانی قوی هستند.

- سرورهای شخصیسازیشده

- برای محیطهای خاص میتوانید سرورهایی با سختافزار سفارشی بسازید.

- این روش ممکن است مقرونبهصرفه باشد اما نیاز به تجربه فنی دارد.

پیشنهاد عملی

- انتخاب CPU با تعداد هستههای بالا برای مدیریت بهتر ترافیک.

- انتخاب هارددیسکهای Enterprise-grade که برای سرورها طراحی شدهاند، مانند WD Gold یا Seagate Exos.

استفاده از منابع تغذیه پایدار

یکی از رایجترین علل خرابی سرورها، قطع برق است. برای جلوگیری از این مسئله:

- از منابع تغذیه UPS با تکنولوژی Online Double Conversion استفاده کنید که برق پایداری فراهم میکند.

- تنظیم Dual Power Supply به شما اجازه میدهد حتی در صورت خرابی یکی از منابع، سیستم همچنان فعال بماند.

استفاده از تجهیزات شبکه پیشرفته

تجهیزات شبکه با استانداردهای بالا (مانند Gigabit Ethernet یا 10GbE) میتوانند پایداری شبکه را تضمین کنند.

- استفاده از سوییچهای مدیریتی که از VLAN و QoS پشتیبانی میکنند، برای جداسازی ترافیک حیاتی و بهبود کارایی شبکه مفید است.

2. زیر ساخت شبکه مطمئن

طراحی معماری شبکه پایدار

یک طراحی شبکه پایدار باید شامل حداقل نقاط شکست (Single Points of Failure) باشد.

- برای اتصال به اینترنت، از حداقل دو ISP استفاده کنید. این کار از قطعی اینترنت جلوگیری میکند.

- استفاده از Mesh Topology به جای Star Topology میتواند احتمال قطعی در یک نقطه خاص را کاهش دهد.

استفاده از پروتکلهای پیشرفته

- پیادهسازی پروتکل BGP برای اطمینان از مسیریابی هوشمند در زمان قطعی شبکه.

- استفاده از Spanning Tree Protocol (STP) برای جلوگیری از مشکلات Loop در شبکه.

مدیریت پهنای باند

- پیادهسازی Traffic Shaping برای اطمینان از اینکه منابع مهم (مانند پایگاههای داده یا APIها) اولویت بیشتری در مصرف پهنای باند دارند.

- ابزارهایی مانند NetFlow یا sFlow برای نظارت و تحلیل استفاده از پهنای باند بسیار مفید هستند.

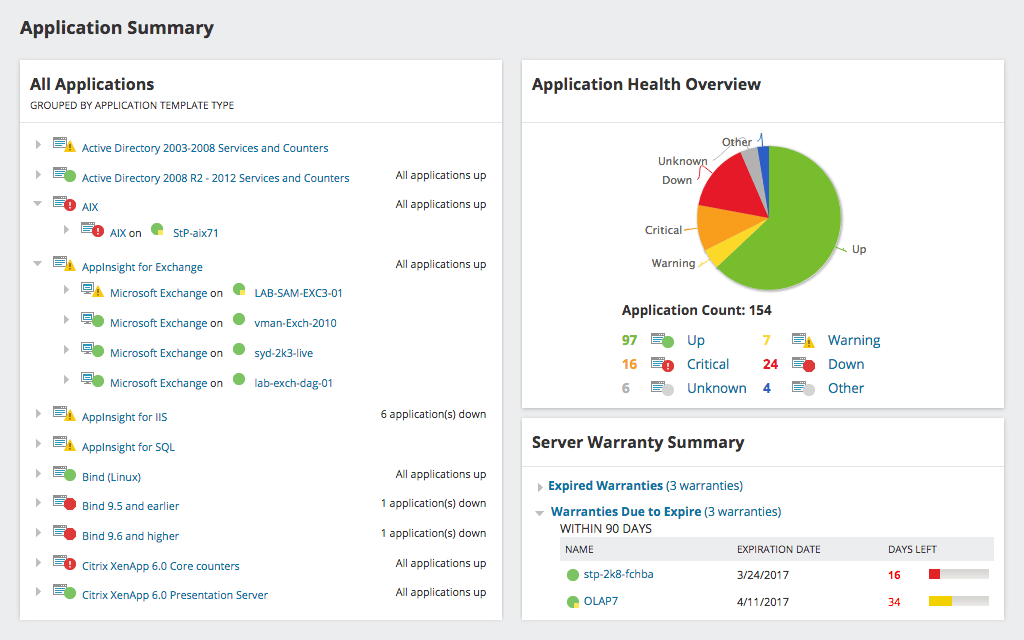

3. مانیتورینگ و نظارت مداوم

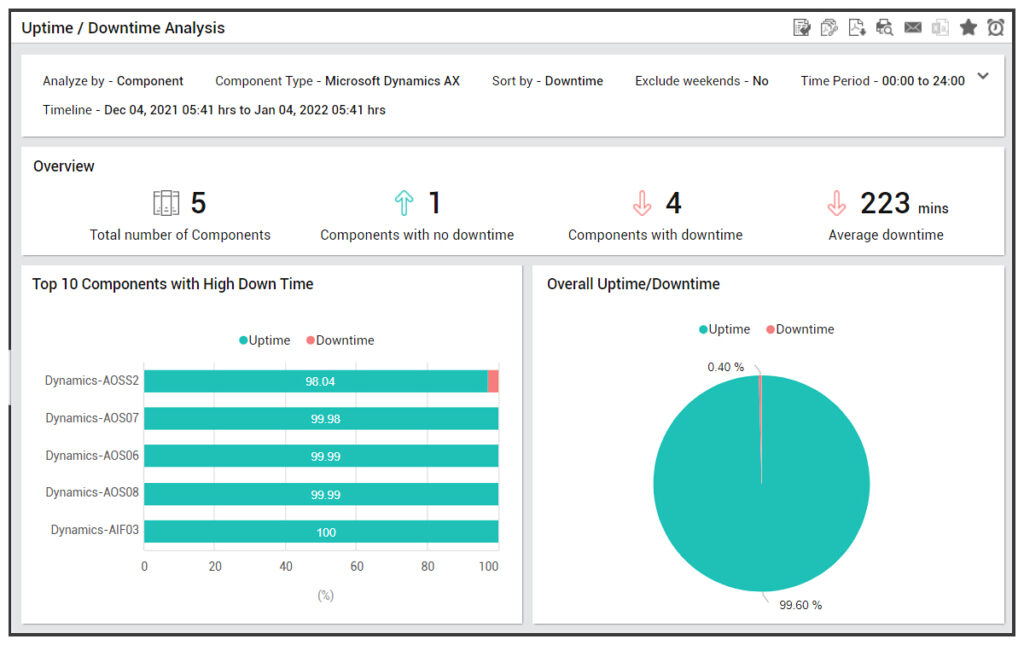

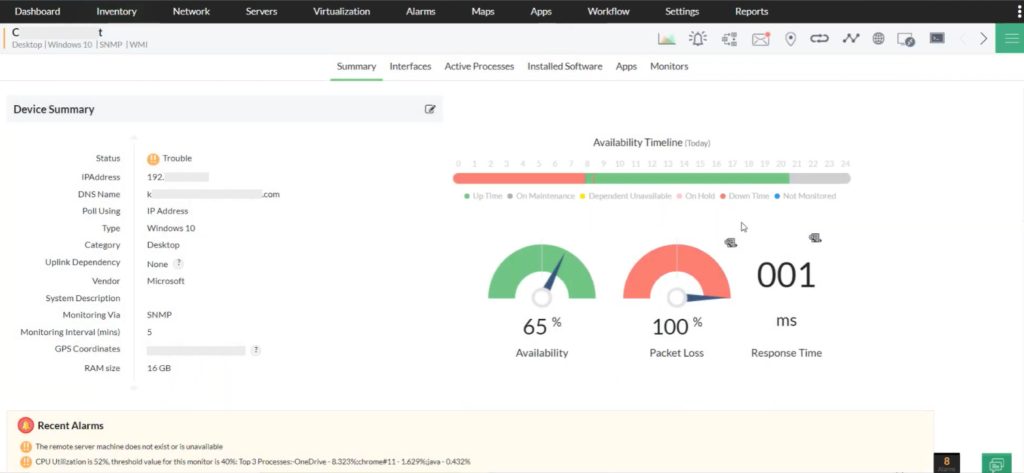

ابزارهای پیشرفته مانیتورینگ

مانیتورینگ یکی از مهمترین بخشهای به حداکثر رساندن Uptime است. برخی ابزارها شامل:

- Prometheus: مناسب برای مانیتورینگ سرویسها و جمعآوری دادهها.

- Grafana: برای بصریسازی دادههای مانیتورینگ.

- Zabbix: برای نظارت بلادرنگ بر سختافزار و نرمافزار.

- Pingdom: برای پایش دسترسپذیری وبسایتها.

تنظیم هشدارهای بلادرنگ

- استفاده از اعلانهای ایمیل، پیامک یا پیامرسانها مانند Slack برای هشدارهای فوری.

- تنظیم معیارهایی مانند CPU Usage، Memory Usage، یا Disk I/O برای ارسال هشدار در زمان عبور از حد تعیینشده.

گزارشدهی و تحلیل دادهها

- استفاده از سیستمهای جمعآوری داده مانند ELK Stack (Elasticsearch, Logstash, Kibana) برای تحلیل لاگها.

- تحلیل دورهای گزارشها برای شناسایی روندها و مشکلات بالقوه.

4. افزونگی و توزیع بار

طراحی سیستمهای افزونگی

Redundancy تضمین میکند که حتی در صورت خرابی یک بخش از سیستم، خدمات به طور مداوم ارائه شوند.

- استفاده از RAID 10 برای ترکیب افزونگی و سرعت.

- ایجاد افزونگی در سطح شبکه (Dual NICs) برای اطمینان از اتصال دائمی.

Load Balancing

Load Balancers مانند NGINX، HAProxy یا AWS Elastic Load Balancer میتوانند ترافیک ورودی را بهطور مساوی میان سرورها توزیع کنند.

- برای برنامههای حساس، از Global Load Balancer برای توزیع ترافیک بین دیتاسنترهای جغرافیایی استفاده کنید.

استفاده از CDN

CDNها به کاهش بار سرورها و افزایش سرعت دسترسی کاربران کمک میکنند.

- ابزارهایی مانند Cloudflare و Akamai برای این کار ایدهآل هستند.

5. بهینهسازی نرمافزار و سیستمعامل

انتخاب سیستمعامل مناسب

- Ubuntu Server: محبوب و کاربرپسند، با جامعه کاربری بزرگ.

- CentOS: مناسب برای محیطهای سازمانی با پشتیبانی طولانیمدت.

- FreeBSD: ایدهآل برای نیازهای خاص به پایداری و عملکرد بالا.

مدیریت بهروزرسانیها

- استفاده از ابزارهای مدیریت پیکربندی مانند Ansible، Chef یا SaltStack برای بهروزرسانی سیستمها بدون Downtime.

بهینهسازی پایگاههای داده

- استفاده از ابزارهای Query Optimization برای کاهش بار روی پایگاه داده.

- پیادهسازی Replication برای پایگاههای داده با ترافیک بالا.

6. امنیت سرور

سیاستهای دسترسی کاربران

- پیادهسازی MFA (Multi-Factor Authentication) برای افزایش امنیت.

- استفاده از ابزارهایی مانند Fail2Ban برای جلوگیری از حملات Brute Force.

مقابله با حملات DDoS

- راهاندازی Rate Limiting برای محدود کردن تعداد درخواستها از یک IP مشخص.

- استفاده از سرویسهای ضد DDoS مانند AWS Shield یا Cloudflare Protection.

7. برنامههای پشتیبانگیری و بازیابی بحران

ایجاد استراتژی پشتیبانگیری

- ذخیره نسخههای پشتیبان در چندین مکان: Local، Remote، و Cloud.

- استفاده از ابزارهای Bacula، Veeam یا Acronis.

آزمایش برنامه بازیابی

- اجرای شبیهسازی سناریوهای بحران هر ماه برای اطمینان از عملکرد.

8. تست و شبیهسازی سناریوهای خرابی

اهمیت شبیهسازی سناریوهای خرابی

یکی از حیاتیترین مراحل برای دستیابی به Uptime بالا، آزمایش زیرساختها برای مواجهه با سناریوهای مختلف بحران است. این شبیهسازیها به شما کمک میکند تا در صورت وقوع بحران واقعی، آمادگی لازم را داشته باشید و خرابیهای احتمالی را کاهش دهید.

پیادهسازی Failover

Failover به معنای جابهجایی خودکار خدمات از یک سرور یا سیستم معیوب به سیستم پشتیبان است.

انواع Failover:

- Failover در سطح سختافزار:

- اگر یکی از سختافزارها دچار مشکل شد، سیستم به صورت خودکار از سختافزار جایگزین استفاده میکند.

- ابزارهای مناسب: vSphere High Availability (HA) برای محیطهای مجازی.

- Failover در سطح نرمافزار:

- برای اپلیکیشنها و پایگاههای داده، استفاده از معماریهایی مانند Primary-Replica میتواند مناسب باشد.

- مثال: در PostgreSQL، از Streaming Replication برای تنظیم یک پایگاه داده اصلی و چندین پایگاه داده پشتیبان استفاده کنید.

- Failover جغرافیایی:

- استفاده از دیتاسنترهای مختلف در مکانهای جغرافیایی متفاوت برای محافظت از دادهها در برابر بلایای طبیعی.

- مثال: پیادهسازی Global Traffic Manager (GTM).

انجام تستهای مداوم

برای اطمینان از اینکه سیستم در صورت خرابی به درستی کار میکند:

- تستهای استرس (Stress Tests): ابزارهایی مانند Apache JMeter یا Gatling برای سنجش مقاومت سیستم در برابر ترافیک بالا استفاده میشود.

- تستهای شبیهسازی خرابی:

- ابزارهای مانند Chaos Monkey از Netflix برای شبیهسازی خرابیهای تصادفی در زیرساختهای ابری بسیار موثر هستند.

- این تستها میتوانند خرابی سختافزار، قطع برق یا حملات سایبری را شبیهسازی کنند.

مانیتورینگ پس از تست

پس از انجام تستها، نتایج باید با استفاده از ابزارهای مانیتورینگ ثبت و تحلیل شوند تا نقاط ضعف شناسایی و برطرف شوند.

9. مدیریت بلایا و بازیابی بحران (Disaster Recovery)

اهمیت Disaster Recovery Plan (DRP)

داشتن یک برنامه بازیابی بحران تضمین میکند که در صورت وقوع فاجعه، عملیات سرور در سریعترین زمان ممکن به حالت عادی بازگردد.

اجزای اصلی DRP:

- ارزیابی ریسک:

- شناسایی ریسکهای احتمالی مانند خرابی سختافزار، حملات سایبری یا بلایای طبیعی.

- اولویتبندی خدمات:

- تعیین اینکه کدام خدمات یا سیستمها باید ابتدا بازیابی شوند.

- مستندسازی:

- تمامی مراحل بازیابی باید مستند شوند و در دسترس تیمها قرار گیرند.

ابزارهای بازیابی بحران

- Veeam Backup & Replication: برای بازیابی سریع ماشینهای مجازی.

- AWS Backup: راهکاری برای مدیریت بکاپ در زیرساختهای AWS.

- Azure Site Recovery (ASR): برای پشتیبانگیری و بازیابی سرورها در محیطهای ابری و فیزیکی.

شبیهسازی Disaster Recovery

- اجرای تمرینات دورهای برای آزمایش برنامه بازیابی و بررسی آمادگی تیمها.

- زمانبندی تستها به صورت ماهانه یا فصلی.

10. نکات پیشرفته برای دستیابی به Uptime 100%

استفاده از فناوریهای نوین

- کانتینرها و Kubernetes:

- کانتینرها مانند Docker قابلیت اجرای اپلیکیشنها را با جداسازی کامل فراهم میکنند.

- Kubernetes میتواند خرابیها را شناسایی کرده و به صورت خودکار اپلیکیشنها را به نودهای سالم منتقل کند.

- Hybrid Cloud Solutions:

- ترکیب زیرساختهای ابری و داخلی برای افزایش انعطافپذیری.

- ابزارهایی مانند VMware vCloud برای مدیریت ترکیبی این زیرساختها مناسب هستند.

- Edge Computing:

- توزیع بار پردازشی نزدیک به کاربران نهایی، کاهش تأخیر و افزایش دسترسپذیری.

پیشبینی مشکلات با هوش مصنوعی

- ابزارهای مانیتورینگ مبتنی بر هوش مصنوعی میتوانند الگوهای خرابی را پیشبینی کرده و قبل از وقوع، هشدار دهند.

- مثال: استفاده از AIOps (AI for IT Operations) در ابزارهایی مانند Dynatrace یا Datadog.

۱1. توسعه تیم فنی و عملیات (DevOps و SRE)

نقش تیمهای DevOps و SRE در Uptime سرورها

یکی از عوامل کلیدی برای دستیابی به حداکثر Uptime، حضور تیمهای تخصصی است که وظیفه توسعه، نظارت، و مدیریت عملیات را بر عهده دارند. این تیمها میتوانند از روشها و ابزارهای مدرن برای اطمینان از عملکرد پایدار استفاده کنند.

تیم DevOps (توسعه و عملیات)

DevOps به معنای همکاری نزدیک بین تیمهای توسعهدهنده و عملیاتی است تا فرآیندهای توسعه نرمافزار و مدیریت زیرساختها بهینهسازی شوند.

مزایای DevOps برای دستیابی به Uptime بالا:

- CI/CD (Continuous Integration and Continuous Delivery):

- ایجاد یک فرآیند پیوسته برای تست و انتشار نرمافزار بدون نیاز به توقف خدمات.

- ابزارهای مرتبط: Jenkins، GitLab CI/CD، و CircleCI.

- Infrastructure as Code (IaC):

- با استفاده از ابزارهایی مانند Terraform و AWS CloudFormation میتوان زیرساختها را به صورت خودکار و بدون خطای انسانی مدیریت کرد.

- Automation:

- اتوماسیون فرآیندهایی مانند مانیتورینگ، بکاپگیری، و بازیابی خرابیها.

تیم SRE (Site Reliability Engineering)

SRE مفهومی پیشرفتهتر است که توسط گوگل معرفی شده و بر اساس اصول DevOps عمل میکند. این تیمها مسئولیت اطمینان از دسترسپذیری و عملکرد سیستمها را دارند.

وظایف SRE:

- خطمشی SLO و SLA:

- تنظیم اهداف مشخص برای زمان دسترسپذیری (Service Level Objective) و سطح خدمات (Service Level Agreement).

- مثال: “99.99% Uptime در هر ماه.”

- خطای بودجه (Error Budget):

- تعریف محدودیتی برای میزان مجاز خرابیها و آزمایشهای پرریسک.

- این استراتژی کمک میکند تا تعادل بین توسعه ویژگیهای جدید و حفظ پایداری برقرار شود.

- پیادهسازی Runbooks:

- مستنداتی که به تیمها کمک میکنند تا در زمان وقوع خرابی سریعتر عمل کنند.

۱2. مستندسازی و مدیریت دانش

اهمیت مستندسازی

یکی از راههای حیاتی برای اطمینان از عملکرد مداوم سرورها، تهیه مستندات دقیق است. مستندات باید شامل همه چیز از پیکربندی سرورها تا مراحل بازیابی بحران باشد.

انواع مستندات ضروری:

- Documentation فنی:

- مشخصات سختافزار، تنظیمات شبکه، و پیکربندی سرویسها.

- پروتکلهای مدیریت بحران:

- شامل مراحل دقیق برای بازیابی سیستمها.

- مستندات آموزشی:

- راهنمایی برای اعضای جدید تیم فنی.

ابزارهای مدیریت دانش

- Confluence: ابزار محبوب برای مستندسازی و به اشتراکگذاری اطلاعات.

- Notion: برای مدیریت دانش تیمی و ایجاد مستندات تعاملی.

- Google Workspace: برای مستندات و همکاری آنلاین.

۱3. آینده زیرساختها: تکنولوژیهای پیشرفته برای افزایش Uptime

هوش مصنوعی و یادگیری ماشین (AI/ML)

هوش مصنوعی میتواند با تحلیل دادههای بلادرنگ، مشکلات احتمالی را قبل از وقوع پیشبینی کند.

موارد کاربرد:

- پیشبینی خرابیهای سختافزاری:

- استفاده از ابزارهای هوشمند مانند IBM Watson AIOps.

- شناسایی تهدیدهای امنیتی:

- پیادهسازی سیستمهای تشخیص نفوذ مبتنی بر هوش مصنوعی.

زیرساختهای ابری پیشرفته

- Serverless Computing:

- کاهش وابستگی به سرورها با استفاده از سرویسهای بدون سرور مانند AWS Lambda یا Azure Functions.

- Edge Computing:

- انتقال بار پردازشی به نزدیکترین نقطه به کاربر نهایی برای کاهش تأخیر.

استفاده از بلاکچین

بلاکچین میتواند در حفظ یکپارچگی دادهها و بهبود امنیت نقش داشته باشد.

مثال:

- پیادهسازی بلاکچین در سرویسهای DNS برای جلوگیری از حملات.

۱4. تحلیل هزینه و بازده (ROI)

ارزیابی هزینهها برای دستیابی به Uptime بالا

- هزینههای سختافزار:

- سرورهای با کیفیت بالا هزینهبر هستند، اما خرابیهای کمتر منجر به صرفهجویی در بلندمدت میشود.

- هزینههای نرمافزار و ابزارهای مانیتورینگ:

- مثال: هزینه لایسنس ابزارهایی مانند Datadog یا New Relic.

محاسبه بازده سرمایهگذاری

- استفاده از KPIهایی مانند Mean Time Between Failures (MTBF) و Mean Time to Recovery (MTTR) برای تحلیل موفقیت استراتژیها.

۱۷. نتیجهگیری جامع

خلاصه اقدامات کلیدی

- سختافزار پایدار: استفاده از تجهیزات پیشرفته و پشتیبان.

- مانیتورینگ مداوم: نظارت 24/7 بر عملکرد سیستمها.

- برنامهریزی بحران: ایجاد و آزمایش برنامههای بازیابی بحران.

- امنیت: پیادهسازی سیاستهای پیشرفته برای جلوگیری از تهدیدها.

- اتوماسیون: کاهش دخالت انسانی و افزایش دقت.

چشمانداز آینده

با پیشرفتهای سریع در فناوری، دستیابی به 99.999% Uptime (پنج نُه) به یک هدف قابلدسترس تبدیل شده است. سرمایهگذاری در فناوریهای نوین و آموزش تیمها کلید موفقیت در این مسیر است.